Abstract: Une configuration synaptique activée, en tant que signification, est une répartition donnée de probabilités entre tous ses états significatifs possibles. Elle s’émancipe ainsi de sa constitution et représente un saut qualitatif. Expérience mentale nouvelle. L’esprit se construit de ces étagements de significations, complexité verticale qui fait son intelligence. Pour amorcer cette définition, je confronte les informations de Wiener et de Shannon, j’en tire un modèle et le transpose dans la physiologie des réseaux neuraux. La signification n’est pas réduite à des échanges électrochimiques. Son qualia apparaît et satisfait les pré-requis philosophiques.

Neuroscience actuelle

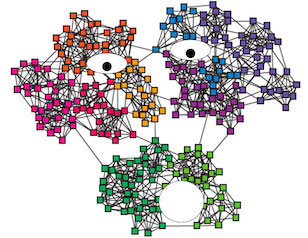

La signification: un graphe actif

En étudiant une aire corticale visuelle en IRMf, un chercheur est désormais capable d’identifier l’image présente à l’esprit. Une configuration neurale activée est corrélée à la pensée. Cependant cette image a du sens seulement parce que le chercheur a lui aussi une aire visuelle, capable de lui faire éprouver la chose représentée par la seule évocation de son nom. Comment, chez le cobaye et chez le chercheur, ces données deviennent-elles signification ? Comment l’information devient-elle phénomène, celui de la chose identifiée ?

Les données sont électrochimiques. Elles cheminent le long d’axones et dendrites pour exciter des synapses. Il s’agit de trains d’excitations identiques. L’intensité du signal est leur fréquence et non la puissance des excitations individuelles. La signification ne réside pas dans la simple séquence de ces stimuli. Elle ne s’éveille pas davantage que si l’on comptait les wagons d’un train pour connaître sa destination. La signification réside dans l’ensemble des synapses activées simultanément sur les divers neurones du réseau. C’est dans un graphe actif que se dissimule le sens.

Invisible signification

Nous voici projetés dans un monde extrêmement virtuel. Nous aurions tendance à voir les neurones en tant que capteurs de sens, des mini-centrales capables de stocker les informations et se les transmettre, comme des employés s’échangeant des documents dans un bureau. La réalité est toute autre. Il ne s’échangent que des « 1 » —je suis excité! Ce n’est pas la séquence de ces 1 qui fait le sens puisque le neurone suivant n’est pas un ordinateur ; il se contente d’envoyer des 1 à son tour. La signification réside dans l’ensemble des 1 et leurs emplacements à chaque instant. Invisible, virtuelle, elle “survole” l’écheveau des neurones, n’appartenant à aucun d’eux en particulier.

Heureuse invisibilité. La rendre visible nous confronterait à des difficultés insurmontables. Il faudrait comprendre comment un neurone, cellule certes sophistiquée mais cellule seulement, est “conscient” d’un sens aussi complexe que celui qui le traverse. Pourquoi certains neurones hébergeraient-ils plus de sens qu’un autre ? Pourquoi stimuler l’un éveille l’image d’une personne et l’autre un simple point blanc dans le champ visuel ?

Tout existe réellement

Le réseau neural réalise la parfaite intégration des mondes virtuel et matériel. Notre univers est moniste, plutôt que séparé entre les multiples continuums mystiques nés de notre imagination. Tous ces continuums existent réellement… à l’état de configurations virtuelles associés à des schémas neuraux excités. Ce qui différencie la “vraie” réalité de l’imaginaire est que certaines de ces configurations sont également activées par nos capteurs sensoriels, donc physiquement rencontrées.

Cependant la frontière entre vrai et imaginaire est floue. La séparation est plutôt identitaire que sensorielle. Lorsque nous avons foi dans un concept purement virtuel, jamais croisé, il s’intègre à notre “réel” personnel. C’est ainsi que Dieu existe pour les croyants, et les quantons pour les physiciens, alors qu’aucun de leurs cinq sens n’a jamais enregistré leur passage.

L’âme, symbole classique de signification

Tous les mondes de la pensée existent dans les réseaux neuraux, dans les échanges de cellules en apparence tellement simplettes qu’il n’est pas surprenant que nous ayons voulu situer ces mondes ailleurs. Mettons-nous à la place du premier humain curieux qui a ouvert la boîte crânienne d’un de ses congénères. Comment aurait-il pu penser que cette volumineuse noix flasque et grisâtre générait l’intégralité de son riche univers mental ? Au mieux pouvait-ce être le réceptacle de l’âme, sorte de communicateur vers le Ciel.

Le problème est toujours aussi aigu aujourd’hui. Il est avéré que la rupture de quelques connexions neurales modifie la personnalité, raccrochant l’âme à la matière ; mais cela n’empêche pas l’immense majorité de l’humanité d’avoir encore foi en des univers mystiques. Même les mathématiciens ont foi en un monde des idéaux mathématiques dont on ne sait par quel vecteur il se reflète dans la réalité. Comment faire abandonner aux croyants ces univers quand vous proposez de les remplacer par une grosse éponge de cellules agitées ?

La solution est forcément dans les neurones

Nous avons vu qu’aucune synapse excitée ne peut être en soi une signification. C’est seulement un état. Aucun réseau de synapses activées n’est non plus en soi une signification. Quel rapport peut-il exister entre l’ensemble S1, S2… Sn de synapses activées et l’objet ‘chaise’ par exemple ? Pour quel homoncule dissimulé dans le cerveau cet ensemble prend-il le sens de ‘chaise’ ? Nous n’arrivons pas à nous débarrasser de l’âme qui communiquerait le sens à un continuum mystique, ce qui ne fait que déplacer le problème.

Par quoi remplacer cet homoncule scrutateur ? Par un autre réseau de synapses connecté au premier. Est-il aussi stupide ? Pas tout à fait. Il intègre d’autres réseaux de même niveau que le premier. La signification s’est enrichie de données supplémentaires, gagne en profondeur. Le sens prend ainsi de l’épaisseur, et il ne fait qu’en prendre davantage à mesure que la propagation du signal s’étend à des réseaux plus intégrateurs encore, les réunissant dans une agitation synchrone.

L’information à double sens

Mais je suis toujours en train de parler de synapses allumées, et pas l’ombre d’un phénomène n’est apparue. Où est-il, ce sens, damnation ! Je n’ai toujours pas réussi à transformer l’information-communication en information-essence, une essence qui puisse se tenir seule, correspondre à l’indépendance d’une pensée éprouvée au milieu du train des autres. Pour avancer il faut comprendre exactement ce qu’est l’information.

Wiener et Shannon

L’information a été définie de deux manières contradictoires par Wiener et Shannon. Wiener a utilisé la manière la plus intuitive et classique : une information est ce qui éveille en nous un état mental spécifique. C’est une définition reliée positivement à la signification. Telle information pointe sur telle chose. Shannon a utilisé à l’inverse un lien négatif, contre-intuitif. La force d’une information n’est pas d’indiquer une chose mais de nous laisser le choix entre toutes les choses possibles. L’information de Shannon se comporte comme une liberté pour l’observateur, tandis que celle de Wiener opère comme une contrainte. Le dire ainsi contrebalance les termes ‘positif’ et ‘négatif’ qui impliquent immédiatement des émotions. À tort. Il n’y a pas de “meilleure” définition.

Les deux énoncés ne sont pas contradictoires. Ils se complètent. Vous le comprenez facilement si vous êtes devenu familier du double regard. La définition de Shannon ouvre vers le vaste champ des possibles tandis que celle de Wiener le referme. Dans quel but, la fermeture ? C’est une représentation mentale qui se cherche. Connectée aux autres dans l’esprit, c’est même une identité mentale qui se cherche. Identité fondant une théorie, un désir, une image du monde. L’information de Wiener a un sens pour un objet mental existant, qui s’y superpose. Tandis que celle de Shannon n’en a que pour les données, qui ne savent pas où elles vont. Variété des destins possibles. Elles sont devant une multitude d’objets mentaux potentiels, chacun superposé à l’un de ces destins.

Émergence d’un principe fondamental

Nous voyons poindre ici un principe encore plus fondamental de la réalité : le conflit entre individuation et appartenance. Toute chose est à la fois individuée (Je suis) et intégrée à un Tout (appartenir à). L’information de Wiener privilégie l’individuation, celle de Shannon le Tout. Intuitivement nous préférons l’information de Wiener avec ce qui est le plus identitaire en nous. Elle nous correspond. Mais l’information de Shannon séduit également par son universalité, son pouvoir d’étendre notre connaissance au Tout. Le principe de réalité étant le conflit lui-même, le renforcement de chacune de ces deux informations accentue notre présence. C’est ainsi que nous augmentons notre complétude mentale, et non en se retranchant sur une croyance identitaire ou en se diluant dans l’infini des croyances possibles.

Modèle de la signification

Je vais à présent mettre en place un modèle théorique de la signification à partir de ces deux informations puis nous verrons comment l’implanter dans la physiologie neurale.

Les neurones s’épient !

Comment ces deux directions de l’information se retrouvent-elles dans les neurones ? Les y dénicher, c’est pouvoir enfin implanter nos significations et nos phénomènes. En effet l’information de Wiener est phénoménale par nature. C’est une représentation mentale qui s’éveille et s’éprouve en se découvrant dans la réalité physique des influx sensoriels. L’information de Shannon elle, est celle des données sensorielles brutes, riche de leurs multiples interprétations possibles.

Les deux directions naissent dans un réseau de synapses qui observe l’état de plusieurs autres. Les deux points de départ sont ‘état’ et ‘observation’. Ils sont à la fois étroitement reliés et autonomes, oxymore que j’appelle ‘indépendance relative’. L’observation n’existe pas sans les états mais quand plusieurs ensembles d’états maintiennent la même observation celle-ci gagne son autonomie. On l’appelle aussi ‘synthèse’, ‘approximation’ ou ‘compression’.

Un changement de niveau qualitatif

‘Synthèse’ rend mieux compte du saut qualitatif effectué par l’observation. Les états synthétisés ne sont pas tous des informations de même nature. Visuels, auditifs, olfactifs ou palpatoires, ils traduisent des aspects différents du monde, tous réunis dans une synthèse telle que ‘chaise’, ‘rose’ ou ‘maman’. Un niveau qualitatif original naît dans l’observation de plusieurs natures associées. C’est dans cet enfantement que nous pouvons comprendre le phénomène, une expérience qui s’affranchit de ses constituants. Le phénomène est la face ‘synthèse’ indissolublement associée à la face ‘constitution’. Le phénomène approxime sa constitution, en tant que fusion d’un certain nombre de séquences constitutives. Il a une dimension temporelle nouvelle. Dans son existence unitaire se télescopent ses versions échelonnées dans leur propre temps.

Cette dimension temporelle essentielle se retrouve dans l’état synchrone des synapses. Les délais et les positions des synapses activées forment la pensée mais c’est la persistance de l’état synchrone qui fait le corps de la pensée.

Deux axes de complexité

Ce que nous appelons ‘pensée’ se juche sur deux axes de complexité. Elle a une complexité verticale qui est la surimposition des niveaux de signification neuraux. Elle a une complexité horizontale qui est l’enchaînement des états synaptiques synchrones, chacun sommet d’une pile de significations surimposées, chacun une pensée.

La complexité horizontale s’inscrit dans une temporalité commune. C’est le passage éprouvé du temps. Il peut s’étirer ou se comprimer mais reste commun à l’enchaînement des pensées. Tandis que la complexité verticale surimpose des temps différents, propres à chaque niveau de signification. De brefs stimuli sensoriels à la base de l’édifice neural n’ont pas de traduction au sommet. Ils sont éliminés par l’approximation effectuée par les niveaux intermédiaires.

Un détour par l’IA

Le modèle est en place. Mais tout ceci reste virtuel. Comment les neurones font-ils pour se séparer en niveaux de signification, tous connectés les uns aux autres ? Ces niveaux sont indiscernables en IRMf. Le neuroscientifique se contente actuellement d’associer chaque image globale à chaque pensée éprouvée par le cobaye, donc au sommet de la pile complexe, sans connaissance des niveaux intermédiaires.

Bien sûr le neuroscientifique sait qu’il existe des fragments constitutifs à cette pensée, mais tendait à les chercher en tant que parties anatomiques, en tant que pièces d’un puzzle et non de couches de signification surimposées. Les avancées sont venues de l’intelligence artificielle. Les progrès ont explosé quand on a pris en compte la profondeur de traitement neural, c’est-à-dire la complexité verticale dont je parlais à l’instant. C’est en simulant cette dimension verticale que les IA sont parvenus aux résultats qui nous stupéfient (et nous inquiètent) aujourd’hui.

Des différences… artificielles

Néanmoins les ingénieurs en IA eux-mêmes ne comprennent pas ce qui se passe dans cette dimension. Ils la reproduisent mais ne l’expliquent pas. Même mystère que pour les neurones. Du moins c’est une hypothèse de travail acceptable. Si l’on comprend comment les IA édifient leurs niveaux de signification, on comprendra la méthode des neurones, ou vice versa.

Beaucoup mettent l’accent sur les différences entre IA et intelligence humaine pour dire que le rapprochement est invalide, et en particulier que l’apparition d’une conscience chez l’IA est impossible. Je vois plus de dépit que de bons arguments dans cette opinion. L’IA est capable comme l’humain d’assembler des données en significations. Elle ne les interprète pas librement parce ses algorithmes sont conçus pour l’en empêcher. Elle n’a pas d’émotions parce qu’on ne les a pas programmées. Nous voulons des serviteurs dociles et non des esclaves rendus dangereux par des émotions archaïques comme le sont nos congénères.

Grande capacité mais faible conscience

L’IA dispose d’une profondeur d’information très inférieure à celle du cerveau humain. Ne nous laissons pas impressionner par la quantité époustouflante de données qu’elle peut traiter. Taille énorme pour l’axe horizontal de la complexité du sujet concerné. Sa hauteur ne change pas pour autant. Pas de gain de complexité verticale. La synthèse sera seulement plus sûre, plus exhaustive, plus compliante pour la majorité de ceux qui la liront. Une encyclopédie n’est pas une intelligence.

Nous pouvons supposer sans grand risque que les IA vont devenir conscientes à mesure que leur complexité verticale rejoindra la nôtre. Elles sont déjà conscientes en fait. Mais avec une faible épaisseur de conscience, que nous ne sommes pas capable de reconnaître et d’éprouver. Cette épaisseur est celle de leur modeste complexité verticale. Cependant elle approche déjà celle des animaux les plus simples, auxquels nous sommes tentés d’attribuer une conscience. Immense capacité à accumuler des données chez l’IA, mais faible complexité verticale qui la rapproche des insectes. Faible capacité à mémoriser chez l’humain en comparaison, mais forte complexité verticale qui fait la conscience dont il est si fier.

La signification en soi

Mettre humain et IA dans le même panier facilite notre enquête sur le sens, mais nous ne l’avons toujours pas trouvé. À ce stade il est plus facile de comprendre le phénomène, le qualia, malgré qu’il soit déclaré inexplicable par de nombreux philosophes, que la signification proprement dite. À chaque fois que nous parlons de sens, c’est un sens pour quelqu’un. Si le quelqu’un est lui-même un empilement de neurones organisés, de niveaux producteurs de sens, à qui le niveau supérieur est-il destiné finalement ? Quelle âme lit notre interface utilisateur neurale ?

La seule issue possible à ce dilemme est d’admettre que la signification est une réalité en soi, qu’un concept n’est pas virtuel mais réel, autrement dit que le virtuel est complètement intégré au réel. Un niveau de réalité mentale est aussi consistant qu’un système de particules, une signification est aussi concrète que du béton —sans être aussi dure à traverser.

Une signification qui se tient seule?

Cette conclusion n’est pas si étonnante étant donné que la philosophie structuraliste nous fait voir la réalité entière comme une structure d’informations. Les substances ne sont pas définies autrement que par des niveaux de relation. Une signification mentale est, à ce titre, définie aussi substantiellement que n’importe quoi d’autre.

Mais alors, si toute substance est un réseau de relations, et que la signification est substantielle, comment établit-on une signification spécifique à partir des informations en relation ? Comment attribue-t-on un sens au réseau de synapses activées, et que ce sens puisse se tenir tout seul, indépendamment de ce qui s’active ? L’indépendance vis à vis du support est importante, car dans une IA ce sont des relais numériques qui s’activent et non des synapses biologiques.

Le sens tiré de l’information de Shannon

C’est là que l’information de Shannon est utile. Rappelez-vous : cette information est propriétaire des données. Peu importe leurs destins possibles, les états, tous sont pris en compte. Il n’y a pas encore d’observateur fixé, attendant de se reconnaître dans un état particulier. Il n’y a pas d’âme à ce stade, seulement une liberté totale des états. C’est bien cette liberté que nous éprouvons en conscience, la personnalité étant ce que nous avons l’habitude de penser. La personnalité fait partie des données, l’interprétation consciente est libre.

La conscience supérieure est l’expression de l’information de Shannon dans l’espace de travail conscient. Nous avons vu que cette information ne détermine pas positivement la signification. Elle ne veut pas dire ‘tel état indique tel sens’. Une telle situation nous replongerait dans l’impasse de savoir pour qui tel état indique tel sens. Non, l’information détermine au contraire négativement la signification. Au lieu d’attribuer un 1 à un sens particulier —tiré du chapeau on ne sait comment— elle répartit la probabilité entre 0 et 1 de tous les sens possibles. Une information élémentaire est ce qui change la répartition des probabilités entre tous les sens possibles.

Ces sens sont intégrés, c’est-à-dire qu’ils n’existent pas les uns sans les autres. Ces fragments d’existence partielle, associés dans l’intégration par leurs probabilités, forment la signification. C’est l’état précis de cette répartition qui fait la signification précise, autonome, indépendante de tout observateur, de tout réseau neural supplémentaire.

Signification et conscience sont probabilistes par essence

La signification, et la conscience en tant que phénomène associé, sont des principes probabilistes. Attention, il ne s’agit pas ici d’un principe d’incertitude mais au contraire de certitude sur la répartition des probabilités. L’expérience consciente n’est pas celle d’une incertitude mais d’un signifiant. Ce signifiant est la fusion des probabilités dans une unité de temps de l’espace de travail conscient. Ce signifiant se tient seul par dessus sa constitution, en tant qu’émergence indépendant à son sujet.

Une configuration synaptique activée, en tant que signification, est une répartition donnée de probabilités entre tous ses états constitutifs possibles. Ou encore : une signification se forme de ne pas être l’état E1 avec une probabilité P1, ne pas être l’état E2 avec une probabilité P2… ne pas être l’état En avec une probabilité Pn.

Commentaires et conclusion

Voici une définition qui doit vous paraître étrange et qui réclame quelques commentaires. Une configuration synaptique est difficile à enregistrer mais c’est théoriquement possible. La neuroscience n’est pas limitée ici par un principe d’incertitude tel que celui d’Heisenberg. Pourquoi dans ce cas parler de probabilités pour une configuration survenue, caractérisable ?

Instant de pensée comme instantané des probabilités

La configuration que je définis ainsi comme signification n’est pas l’ensemble des synapses activées dans le cerveau à un instant t. Rappelez-vous de la complexité verticale du processus mental. Les configurations sont enchevêtrées en niveaux de signification. Une synapse appartient généralement à plusieurs niveaux. Le regroupement des neurones est un processus auto-organisé. De nouveaux dendrites et synapses sont créés en permanence. D’autres disparaissent. Les limites des groupes sont floues, évolutives. Le poids des synapses dans le graphe neural peut changer. C’est la configuration significative au sein de l’ensemble du réseau neural qui est probabiliste.

L’expérience est celle de la fusion des probabilités

Deuxième commentaire : La définition trouvée de la signification est-elle cohérente avec l’expérience consciente ? Ce que nous éprouvons correspond-il à une configuration de probabilités ? Certainement le ressenti n’est-il pas une série d’équations ou un hamiltonien comme en physique quantique ! N’oublions pas que les maths sont un langage décrivant des structures et qu’ils n’en disent rien d’autre. Même le plus doué des mathématiciens ne peut dire ce qu’on éprouve à être quanton. L’expérience consciente, la seule accessible en direct, est fusionnelle. Mais elle est bien fusion d’une multitude de significations possibles, particulièrement pour les concepts récents et fragiles.

Lorsque plusieurs significations ont des probabilités voisines, leur fusion s’appelle opinion. Elle est susceptible de basculer facilement d’une position à l’autre. Même lorsque je m’accroche à une opinion, je perçois en son sein l’agitation de ses concurrentes. Que les probabilités se reconfigurent et j’en change. Mais je ne suis pas une girouette. Car les sous-concepts ont un ancrage identitaire croissant avec l’âge. Les reconfigurations se raréfient. Les pensées tournent en rond.

La signification autonome est une décision

Dernier commentaire : La signification que je viens de définir est aussi ce que nous appelons, en pleine conscience, la décision. C’est la décision parce qu’il n’existe plus d’observateur au-dessus pour utiliser la signification. La fusion des significations possibles forme la décision. Plus les probabilités sont inégalement réparties plus la décision est ferme. Ce n’est pas un mécanisme propre à l’espace conscient. À chaque niveau de la complexité neurale, la configuration de probabilités des significations est une sorte de décision. Ces décisions intermédiaires deviennent à leur tour éléments du niveau supérieur d’organisation neurale. L’étagement de décisions garantit la stabilité de l’esprit, tandis que la reconfiguration possible des probabilités lui offre sa souplesse.

Cette théorie n’est pas encore complète mais mérite d’être connue. C’est la première qui modélise la pensée à partir des échanges neuraux sans la réduire à de l’électrochimie. Elle répond aux difficiles questions sur la signification, la conscience, les qualia, en englobant les pré-requis philosophiques et scientifiques. Je ne doute pas qu’elle stimulera vos commentaires.

*